(SeaPRwire) – 想象一下,通过一个六个月大的孩子的眼睛来看世界。你没有语言来描述任何东西。当周围人的嘴里发出的每一个声音都有无数个潜在的含义时,你如何才能开始理解语言呢?

这个问题导致许多科学家假设,人类必须具有一些先天的语言能力来帮助我们开始习得语言。但是,本周发表在科学杂志上的一篇论文发现,一个相对简单的 AI 系统通过婴儿视角拍摄的数据开始学习单词。

这篇论文建立在对一个澳大利亚婴儿从六个月到 25 个月大的十八个月期间佩戴的头盔式摄像机拍摄的素材进行的研究 。研究助理们费力地整理和注释了 37,5000 条话语(例如,“你看这个三角形积木”,当婴儿玩玩具积木套时父母所说),这些话语来自 61 小时的视频。与时代周刊分享的一个片段显示,婴儿在把注意力转向一只不为所动的猫之前,在抓取玩具套。

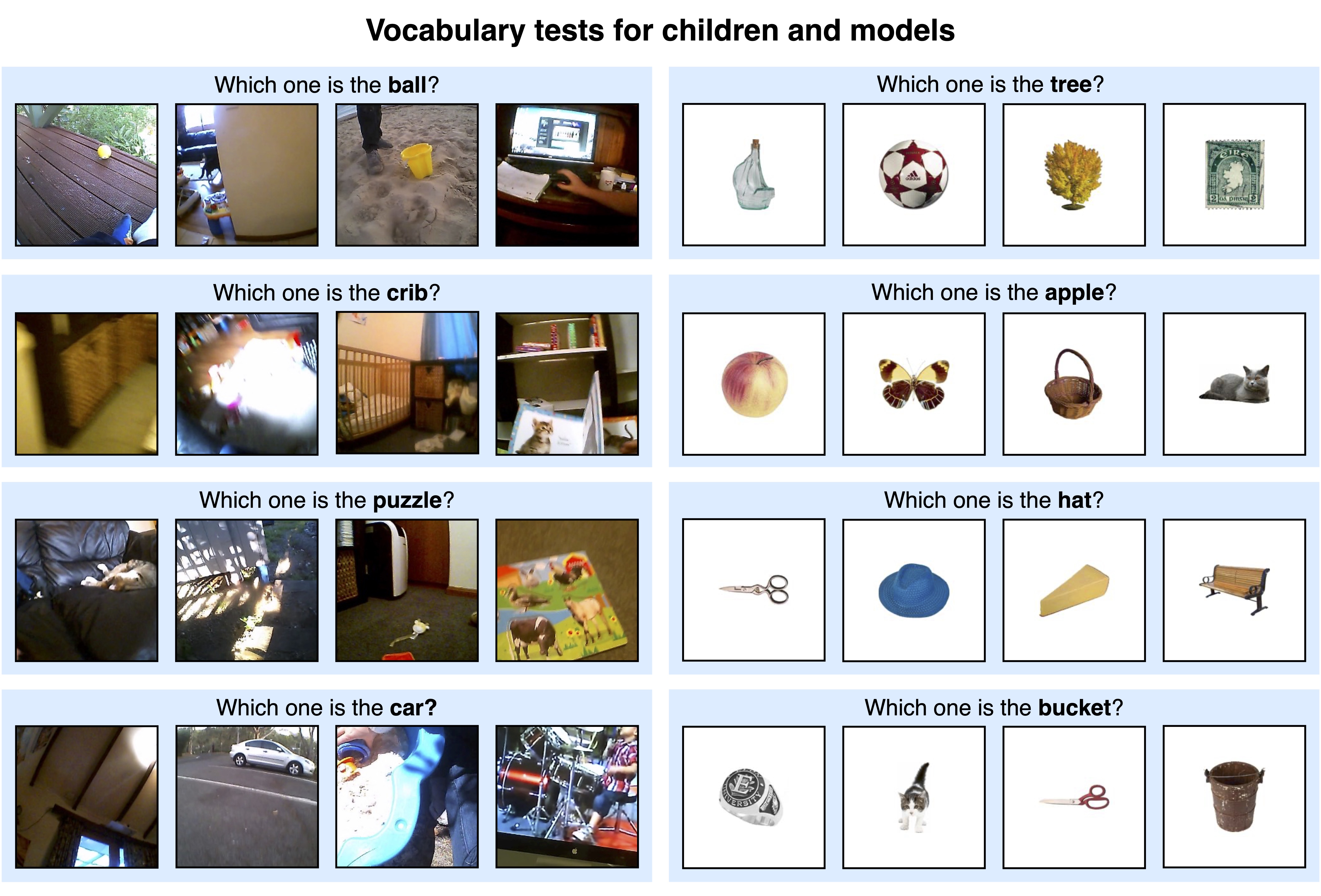

纽约大学数据科学中心和心理学系的的研究人员将此数据集输入了一个多模态 AI 系统,该系统可以同时读取文本和图像。他们发现 AI 模型可以识别许多不同的物体,无论是在使用来自头盔摄像机数据的测试还是使用各种物体理想化图像的数据集的测试中,尽管其准确性有些有限。

AI 系统更擅长命名它更频繁看到的物体,包括苹果(在儿童读物中很常见)和婴儿床。它还能够更好地挑选出未在头盔摄像机图像中遮挡的物体。论文的作者之一王启贤说,它尤其不擅长识别刀子。

一些心理学家和语言学家认为,儿童在没有某种先天语言能力的情况下无法在单词和物体之间形成关联。但王启贤说,这个相对简单的 AI 模型甚至可以在如此小的数据集上开始学习单词关联这一事实,对这种观点提出了挑战。

然而,值得注意的是,摄像机收集的录像捕捉到了婴儿与世界的互动及其父母对它的反应。麻省理工学院计算机科学与人工智能实验室的研究科学家安德烈·巴布表示,这意味着 AI 模型正在“获取孩子的知识”,使其在发展单词关联方面具有优势。 “如果你使用这个模型并把它放在机器人上,让它运行 61 个小时,你将无法获得他们在这里获得的那种数据,然后这些数据将可用于更新这样的模型。”

自写下他们的研究结果后,纽约大学的研究人员已经从头盔摄像机录像中转录了四倍多的数据,他们打算将其输入他们的模型。王启贤说,他们希望研究当 AI 模型获得更多数据时可以学习到多少更多的知识。他们还希望测试该模型是否可以开始学习更具挑战性的单词和通常在生命后期发展的语言行为。

这些实验可以进一步阐明婴儿如何学习说话,并帮助研究人员理解人类和人工智能之间的差异。王启贤说:“从研究人类如何习得语言中可以汲取大量知识,以及我们与现在机器相比如何做到如此高效。”

本文由第三方内容提供商提供。SeaPRwire (https://www.seaprwire.com/)对此不作任何保证或陈述。

分类: 头条新闻,日常新闻

SeaPRwire为公司和机构提供全球新闻稿发布,覆盖超过6,500个媒体库、86,000名编辑和记者,以及350万以上终端桌面和手机App。SeaPRwire支持英、日、德、韩、法、俄、印尼、马来、越南、中文等多种语言新闻稿发布。